Highway Network & Grid LSTM

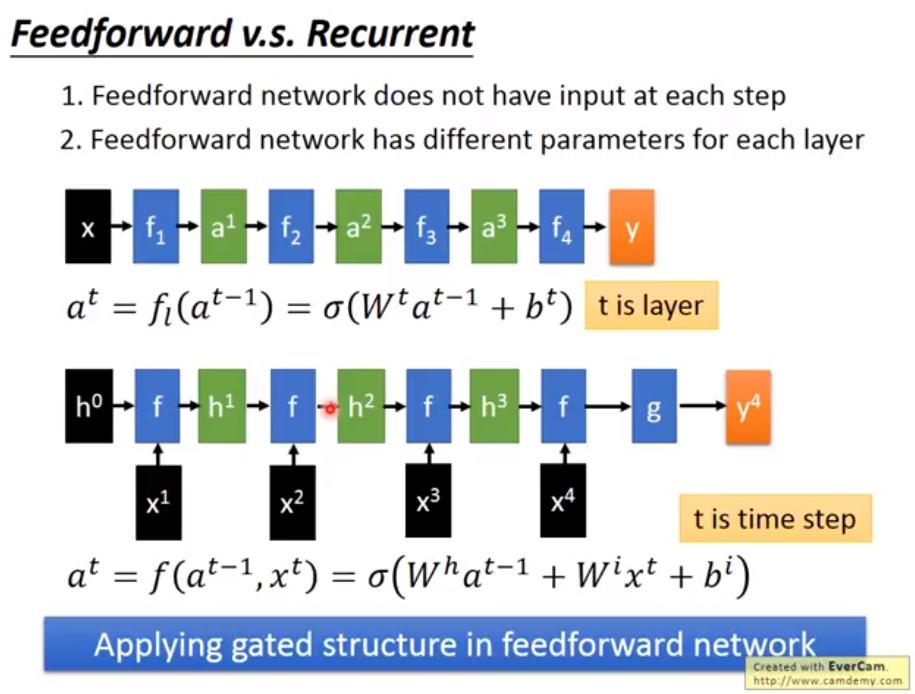

Feedforward v.s. Recurrent

RNN 和 FF 不同處

RNN 和 FF 不同處

- FF 每層不會有額外 input 和 output

- FF 每層的 parameter 是不同的

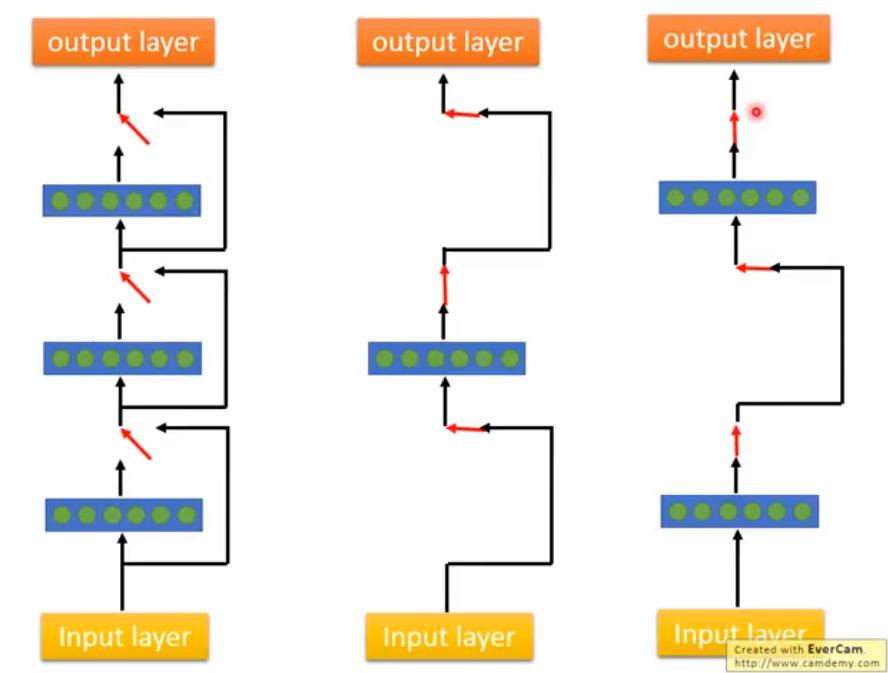

現在要把 RNN 豎直,變成 FF,看能不能學一個很 deep 的 network

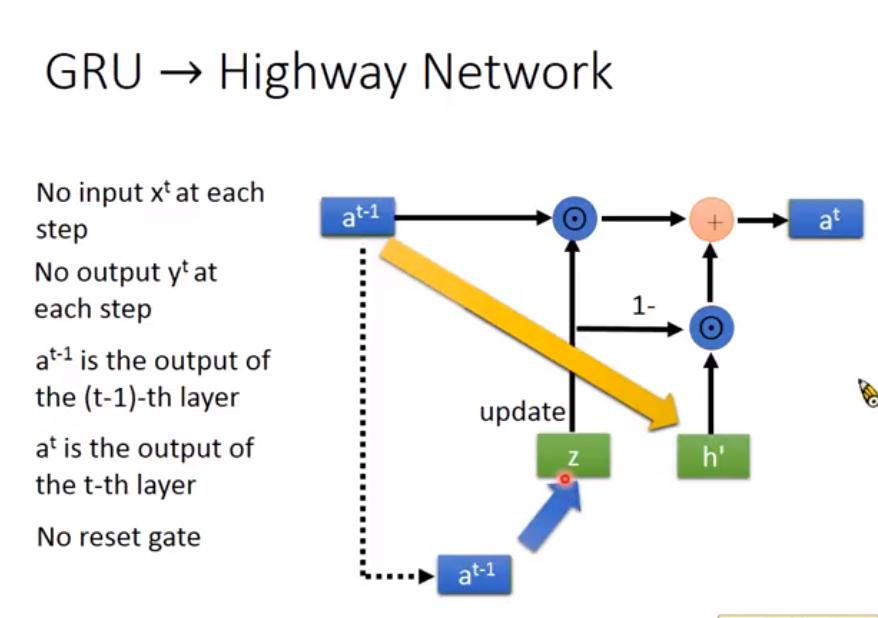

GRU -> Highway Network

從 GRU 的改動

從 GRU 的改動

- 每個 step 不再有 input ,以及 output

- 改 notation, (不同step的 output)變成 (不同層的 output)

- 沒有 reset gate (forget gate?),避免忘記前幾層的 output

- 所以每層 layer 參數到底一不一樣RRRRR

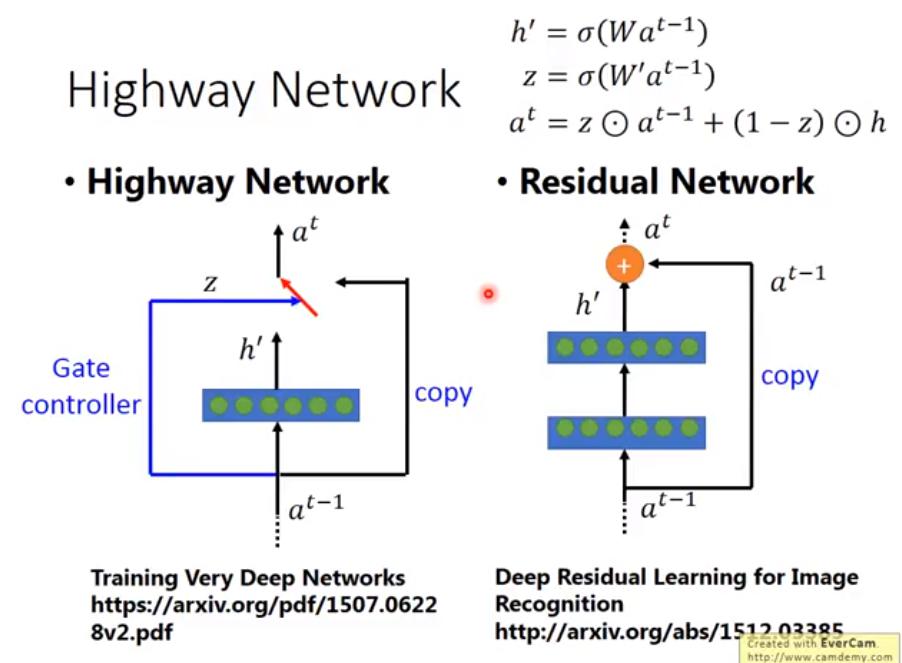

- 有人說把 LSTM 豎直就是 Residual Network

- Residual Network 直接不 control 了,直接相加

- 等於可以自動 control 需要多少個 layer

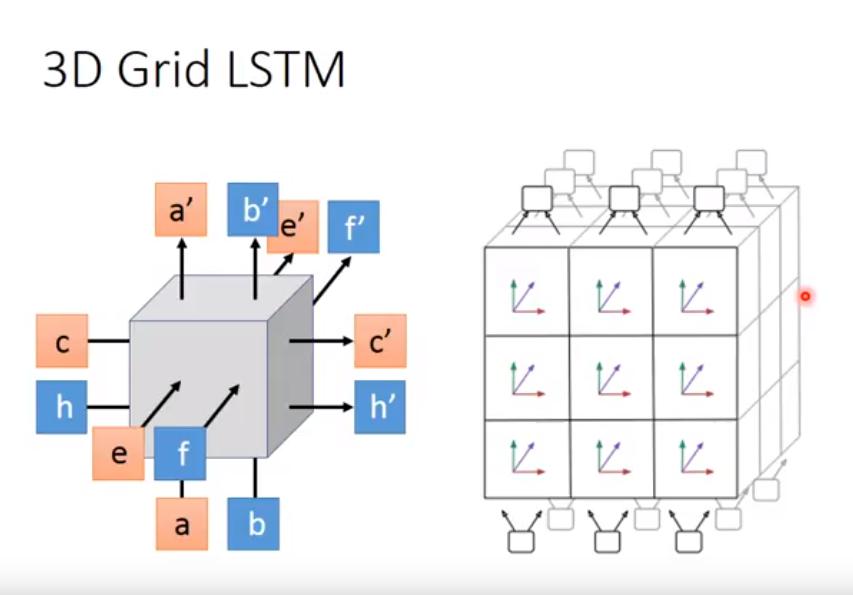

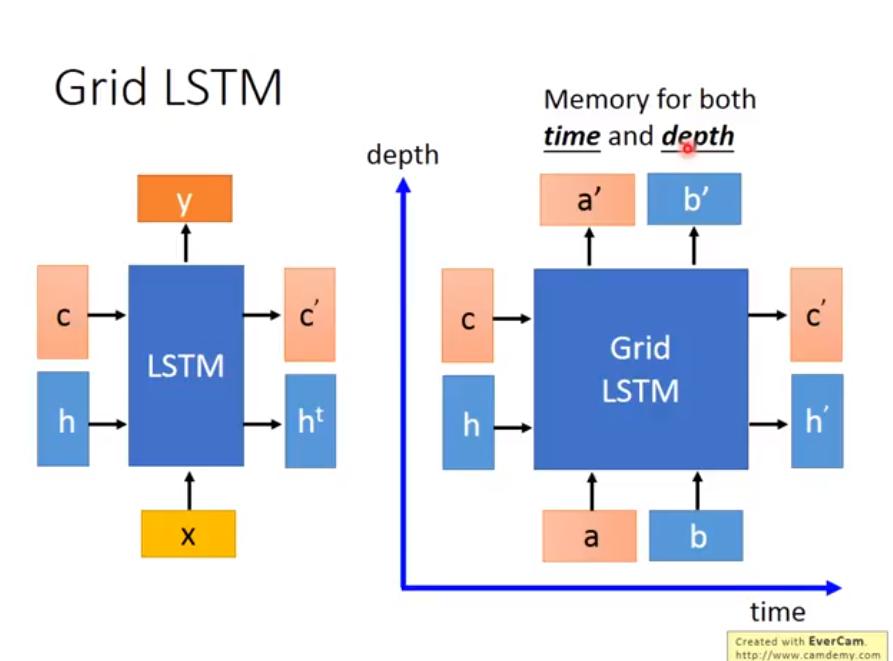

Grid LSTM

什麼東西 好屌

用到 Highway Network

LSTM (左) 和 Grid LSTM (右) 的區別

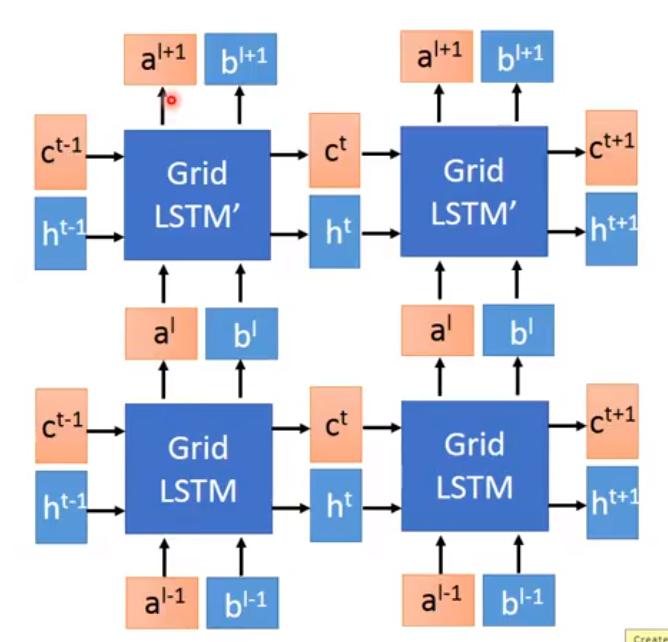

Grid LSTM 怎麼疊

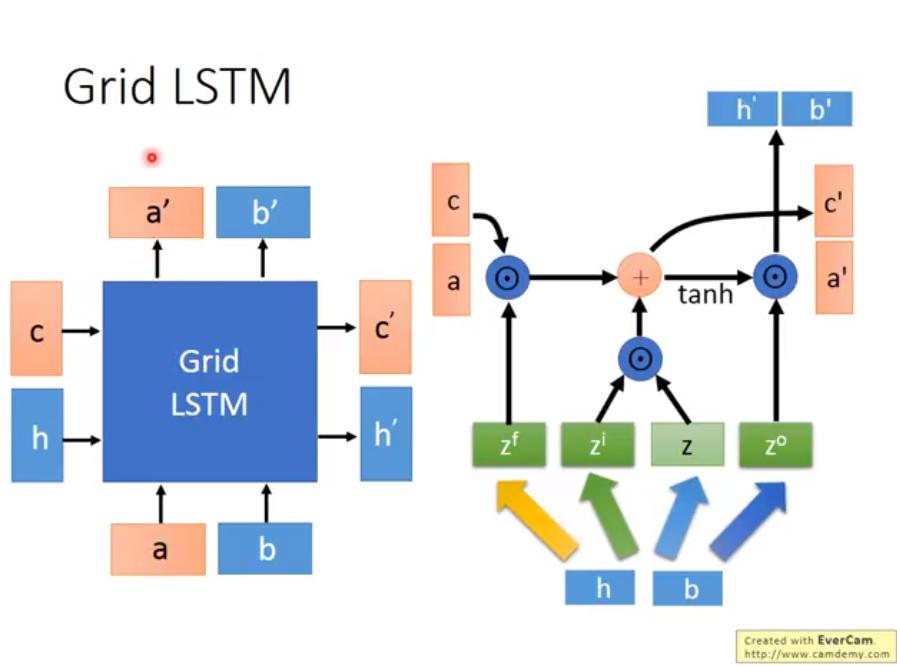

Grid LSTM 內部結構

3D Grid LSTM