ML Lecture 13: Unsupervised Learning - Linear Methods

PCA

- 降成k維

- 找出k個向量,是各feature的線性組合(),並使得data投影到這k個向量的variance最大

- 但是a1、a2...有可能為負值,也就是說投射到的vector可能會是較複雜的pattern,然後刪除某些pattern之後才是要預測的那個Class的特徵,易讀性(可解釋性)較低

- Non-negative matrix factorization(NMF)

- 強制 a1、a2....為非負

- Non-negative matrix factorization(NMF)

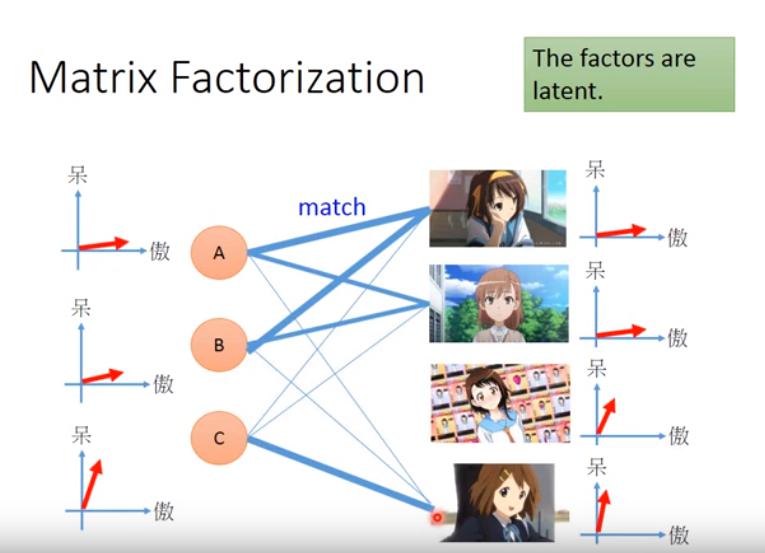

Matrix Factorization

- 用在文字上就是Latent Semantic Analysis(LSA)

- 此時的latent factors就是topic