Lecture 18: Unsupervised Learning - Deep Generative Model

VAE

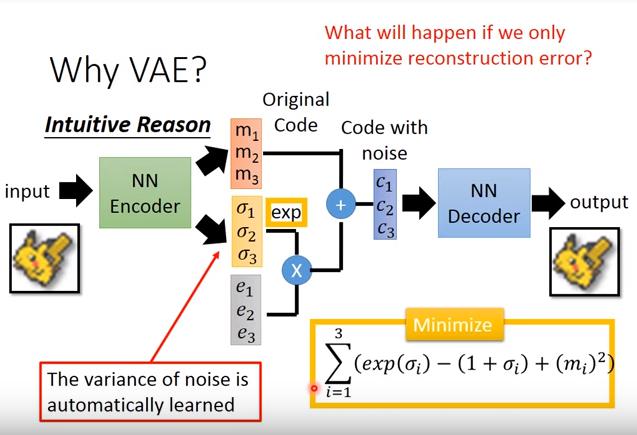

- 一般autoencoder是在encode之後會產生出code,然後decoder會把它還原成原圖

- VAE在encode後會在code上加入noise,並且希望在某張圖encode之後,它附近的code也能還原成原圖

(noise的variance)不能太小

需要估計P(x)的大小,才能sample出比較有可能的x

- 使用 Gaussian Mixture Model

- P(m):data屬於這個gaussian的機率

- P(x|m):data在這個gaussian中,被取出的機率

:根據x所產生的mean

- :根據x所產生的variance

Conditional VAE

- 以MNIST而言,輸入某個digit(例如4),可以畫出同樣style的其他digit(0~9)

Problems of VAE

- 只會模仿,無法以假亂真

Generative Adversarial Network

- 訓練generator時,需要固定住discriminator的參數

難點:

- 無法知道generator騙過discriminator時,到底是因為generator表現很好還是因為discriminator太爛了

- 同理,discriminator表現很好時,也無法知道到底是不是generator產生的東西太爛了,導致discriminator看起來好像做得不錯

較有用的tip是使得discriminator更加穩健(robust)