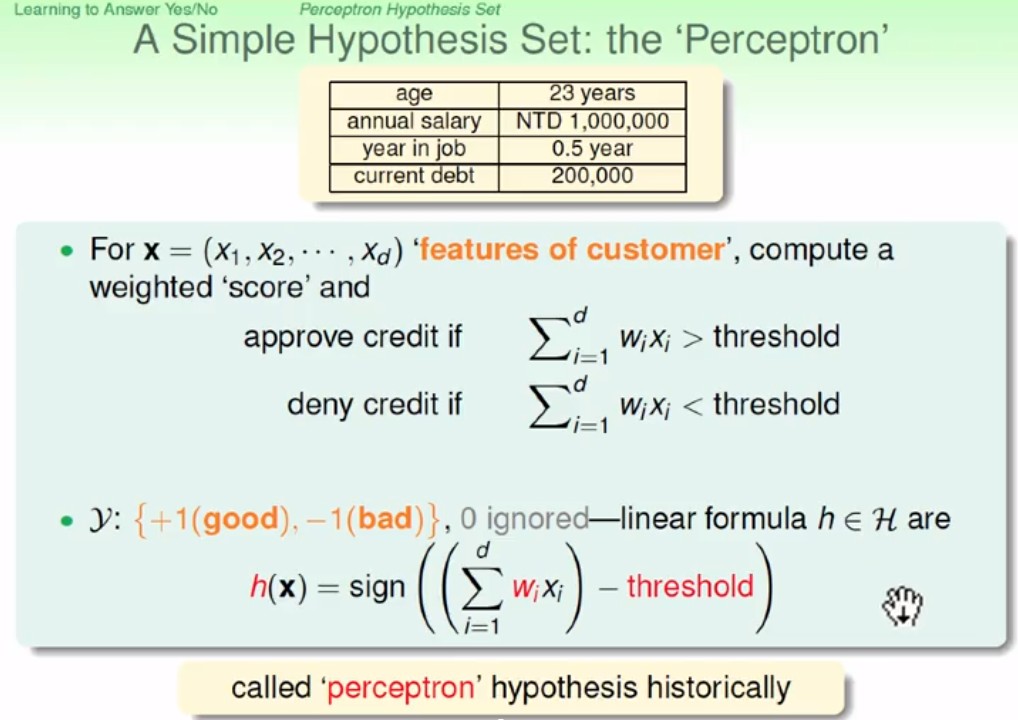

Perceptron Hypothesis Set

Perceptron

找出各個的權重, 並判斷是否大於threshold(門檻), 是則輸出1, 否則輸出0

找出各個的權重, 並判斷是否大於threshold(門檻), 是則輸出1, 否則輸出0

- : 判斷正負號, 大於0則輸出1, 小於0則輸出-1

- 可以將 表示為 , 值為(-threshold), 值為1

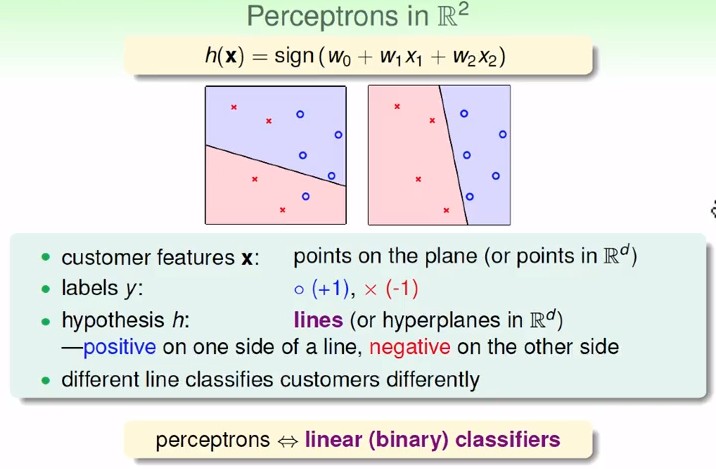

- perceptrons 又可稱線性分類器

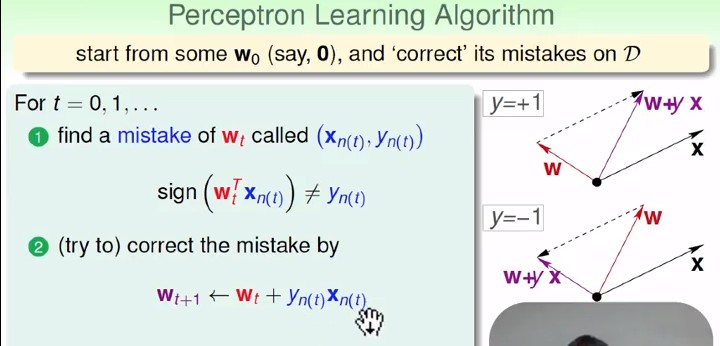

Perceptron Learning Algorithm (PLA)

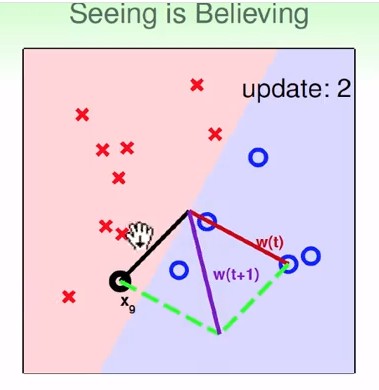

PLA如何逐步修正直線

當實際的結果(y)是正的,它(wx)跟我說負的,代表這個w跟x的角度夾角太大,修正的方式就是把它轉回來,把w跟x加起來成為新的w,那麼結果可能就會是正的,另外一種可能性,實際結果(y)是負的,結果它(wx)跟我說是正的,那代表w跟x的角度太小了 我就把w減掉x

- PLA的進行 看影片較清楚

- 注意: w在圖中為分界線的法向量

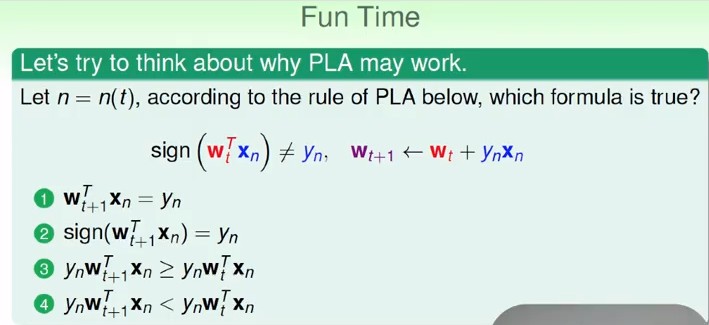

Ans: 3

將 等號兩邊乘上 即可得知3正確

Ans: 3

將 等號兩邊乘上 即可得知3正確

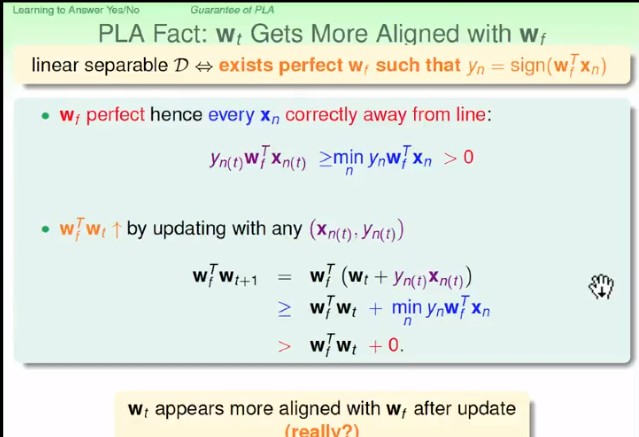

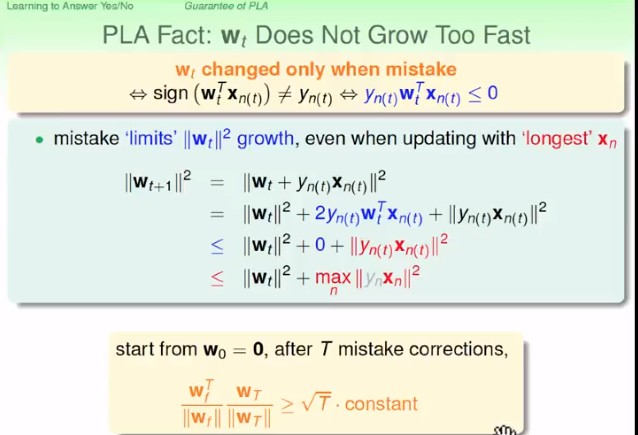

Guarantee of PLA

- : 我們想要的那個未知的w

- : 那條線與點的距離(不知道為啥)

- : 離線最近的點距離乘上y

- , : 第t次算出w犯錯的那個點的x和y

- 向量內積越大通常代表兩個向量越接近, 即 比 更接近

- 但是 也有可能單純是因為 的長度比 更長, 導致我們以為 比 更接近

- 這裡證明了 , 也因此我們可以確定 比 更接近

最後那個問題不會解 ˊˋ

Non-Separable Data

Pocket Algorithm

- 在PLA過程中, 把最好的weight(犯最少錯誤)存著(在pocket中), 比較當前weight的表現