Logistic Regression as a Neural Network

Binary Classification

Logistic Regression

可以參考這個

Linear Regression 找出 和 使得 最貼近真實資料的 , 即使得cost function最小化

Logistic Regression 找出 和 使得 最貼近真實資料的 (範圍為0~1)

Sigmoid Function

Logistic Regression: cost function

Linear Regression的 Loss(Error) Function一般使用Square Error 但是Logistic Regression 的 Loss Function使用 註: 為實際資料y值, 為預測出來的y值

Cost Function使用training data中每一筆資料經由 Loss Function算出來的結果做平均 註: 即第i筆資料的y值

Gradient Descent

重複以下步驟:

註: 為 learning rate

Derivatives

More Derivatives examples

Derivatives of a Computation Graph

以 為例子

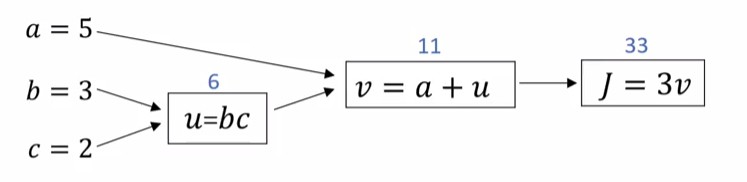

Computation Graph會長這樣

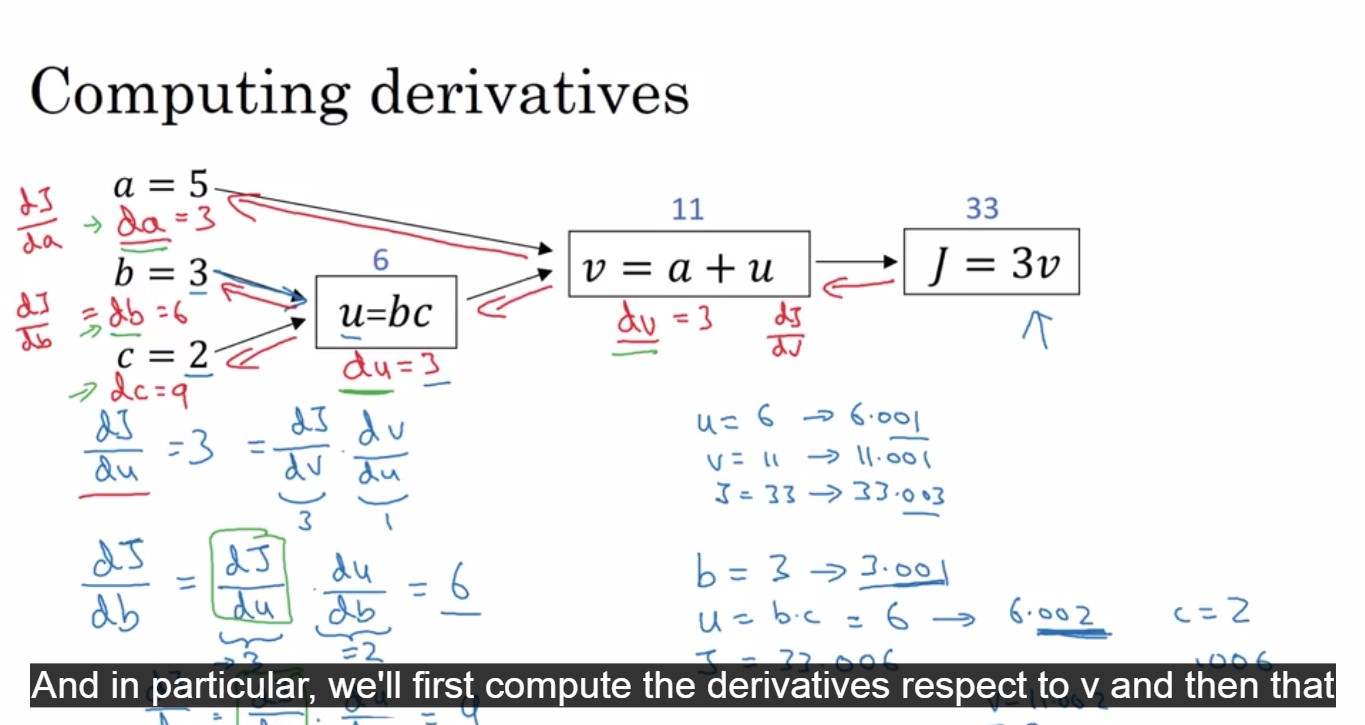

在寫code的時候, 我們姑且以 d_a 表示 , 其他諸如d_u, d_v等以此類推

下圖為計算d_a, d_b...

Logistic Regression Gradient Descent

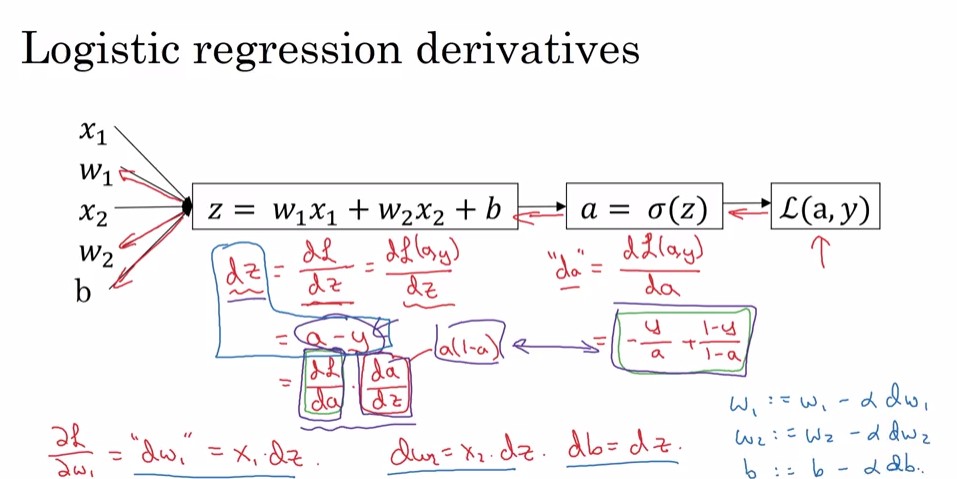

Backpropagation 的目的: 經由最終的Loss Function來回推 中的各個 應該以什麼比例來調整, 如下圖

計算:

所以

Gradient Descent on m examples

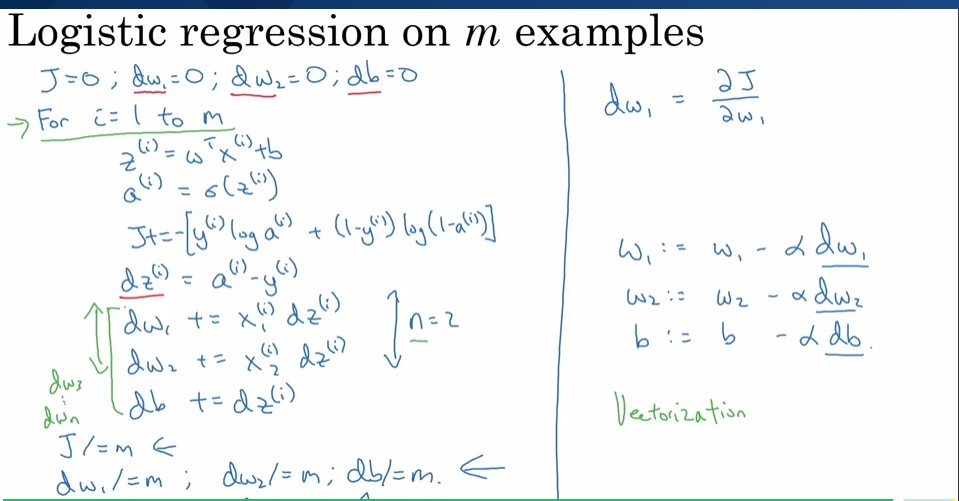

for i = 1 to m

for i = 1 to m

- 算z和a是為了算誤差(J)總和, 最後再除以資料數量m

- 算dz是為了計算dw和db(w和b對cost function的影響)總和, 最後再除以m